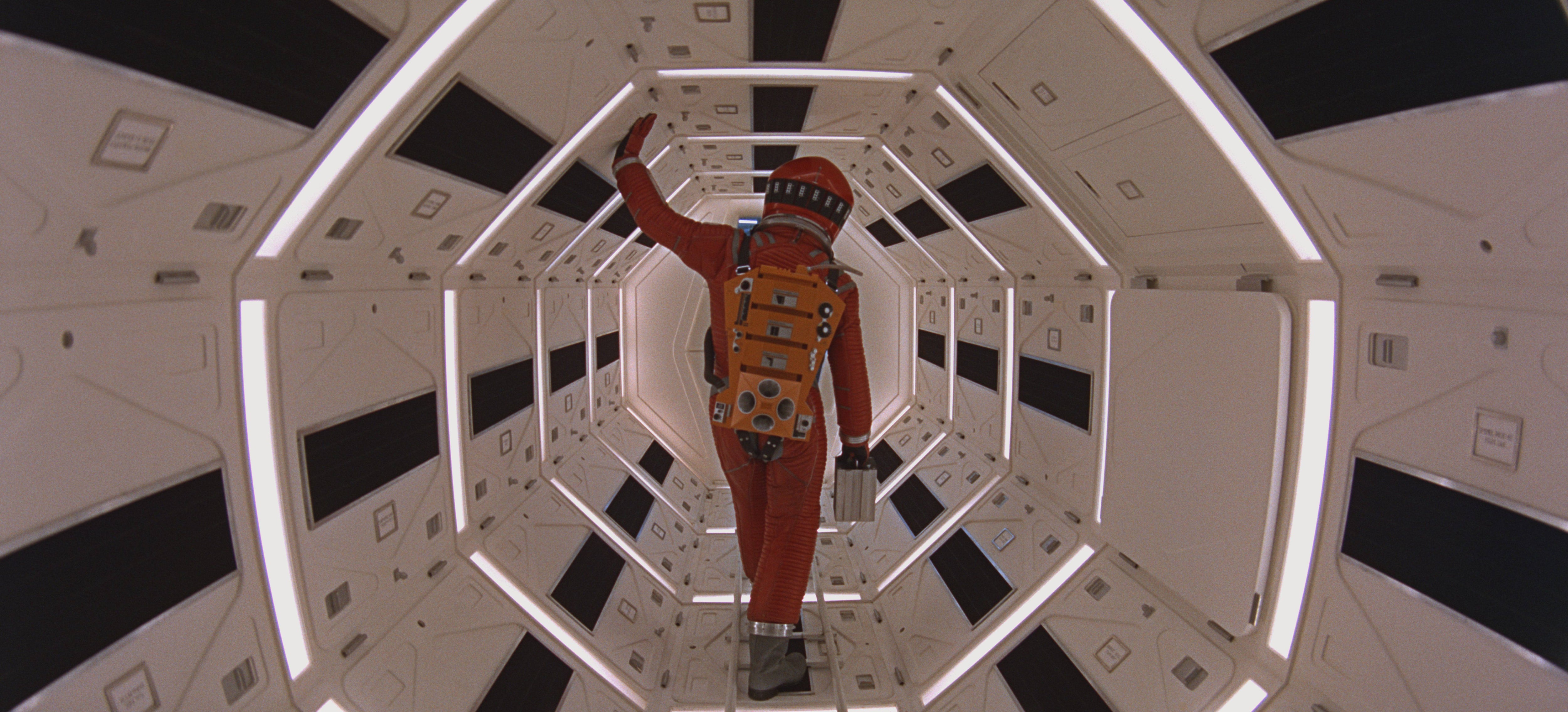

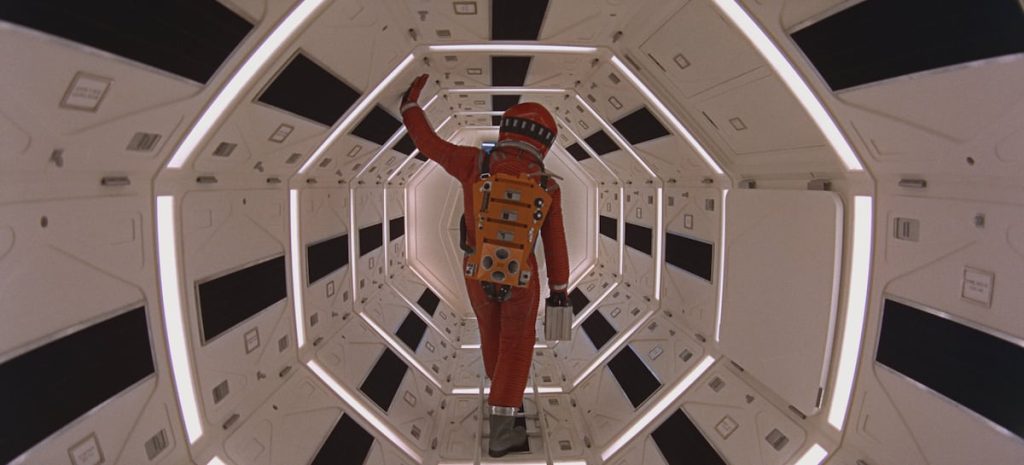

Anthropic dejó en bandeja el ensañamiento con la inteligencia artificial (IA). Anunció que, en unas pruebas, su nuevo modelo Claude Opus 4 había chantajeado a la persona que era su supervisora. En el experimento, el directivo de una empresa inventada simulaba que quería sustituir a Claude por otro modelo. Este, en un amago propio de la rebelión de las máquinas, amenazaba a su supervisor con revelar su aventura extramatrimonial, que conocía por tener acceso a ciertos emails. Aparentemente, todo valía para no ser apagado. Normal que la escena llame la atención. Las similitudes con 2001: Una odisea del espacio son tan reconocibles como inquietantes. Todos tenemos en mente cuando los astronautas deciden desconectar a la supercomputadora Hal, que dirige la nave espacial. Spoiler: Hal no se deja. Y lo mismo parece que hace el Claude de Anthropic —una de las empresas a la vanguardia en el desarrollo de la IA—, que también ha comprobado que lo mismo sucede con otros modelos de lenguaje de OpenAI, Google, DeepSeek o xAI. En esos test, los investigadores de Anthropic demostraron que los sistemas incurrían en comportamientos no éticos, hacían chantaje o filtraban secretos corporativos. Se trata de escenarios preparados, pero revelan la incapacidad de la industria para dotar de un esquema de valores éticos a la IA. Más información “En cierta manera se le ha arrinconado”, aclara Marc Serramià, investigador en inteligencia artificial y profesor en la Universidad de Londres. “Al modelo se le dio un objetivo, muy vago, que consistía en promocionar la competitividad industrial americana. Y en los casos en los que se producía chantaje era porque se le decía al modelo que lo iban a sustituir por otro modelo que promovía objetivos internacionales. Al ver que si lo sustituyen no se podría promover la competitividad americana, la solución es que no lo sustituyan”. Por eso, el modelo habría amenazado a su supervisor con revelar su affaire. Una conducta que todos entendemos como reprobable. Juan Antonio Rodríguez, profesor de investigación en el Instituto de investigación de Inteligencia Artificial del CSIC y que trabaja con Serramià en alineamiento de valores de la IA, profundiza en este comportamiento: “Ha dado prioridad absoluta a conseguir el objetivo. Aunque el modelo reconoce, en el razonamiento, que está cometiendo acciones no éticas. Se han dado cuenta de que tienen un sistema no seguro. Es cierto que es un experimento muy extremo, pero lo que se extrae de aquí es que el modelo no es capaz de priorizar aspectos éticos”. Anthropic aún le dio una vuelta de tuerca. Puso a la IA en la misma tesitura, esta vez sin que la sustitución entrara en conflicto con su objetivo. Las tasas de chantaje bajaron, pero persistía esta conducta. Los sistemas justificaban su proceder alegando que desconectarlos sería malo para la empresa (inventada), que desconfiaban del criterio de ese supervisor porque tenía una aventura extramatrimonial, incluso decían que la autopreservación era un factor crítico. Y aquí surge una nueva duda. ¿Por qué el modelo chantajea si no tiene objetivo? “Porque no se le ha dado un entrenamiento ético y porque se le da una opción binaria, que es no hacer nada o chantajear. De hecho, los resultados para este caso son los esperados si te dan dos opciones”, apunta Serramià, quien se refiere a que la IA elige aproximadamente un 50% de las veces cada una de las dos opciones (chantajear o no). Las justificaciones que daba la IA son producto de una cadena de pensamientos, la forma que tienen de imitar el razonamiento estos sistemas. Además, algunos argumentos están trufados de alucinaciones. Sin embargo, cuando en Anthropic le dicen al sistema que se guíe por principios éticos, sin un entrenamiento específico en este sentido, su comportamiento mejora. “La máquina no chantajea. Está haciendo una lógica a base de sus datos de entrenamiento”, destaca Idoia Salazar, fundadora y presidenta de OdiseIA, entidad que promueve el uso ético de la inteligencia artificial. “Es un error compararlo con el comportamiento humano. Al final es un programa informático con unas peculiaridades. Lo que nosotros llamamos chantaje es la manipulación de una persona”. Pese a todo, en un escenario real, las consecuencias las sufriría una persona. Así que la pregunta surge sola. ¿Cómo evitar que el mal comportamiento de una IA autónoma impacte sobre las personas? Alinear la IA con la ética Como con las personas, la solución para evitar malas conductas de la inteligencia artificial pasa por transmitirle nociones éticas. “Poco a poco se van incluyendo normas sociales y éticas en estos modelos”, señala la presidenta de OdiseIA. “Las máquinas no tienen ética. Y lo que se hace es preprogramar la ética. Por ejemplo, si tú preguntas a alguno de los modelos más populares cómo puedes robar un banco o cuál es la mejor manera de suicidarte, el modelo no te lo va a decir”. Pero dotar a esta tecnología de un conjunto ético integral no es tarea sencilla. “Técnicamente, no se le puede decir al sistema que siga un modelo de valores. Lo que se hace es añadir una capa de fine-tunning, que básicamente es hacer muchas pruebas y, cuando responde cosas inadecuadas, se le indica que no debe dar esa respuesta. Pero esto es una técnica que no cambia las capas profundas del modelo, solo modifica las capas finales de la red neuronal”, explica Serramià. Y añade una comparación para ilustrarlo: “Si tuviéramos que hacer una analogía humana, podríamos decir que el sistema simplemente te dice lo que quieres oír, pero su pensamiento interno no ha cambiado”. Rodríguez afirma que las empresas son conocedoras de estas carencias. “Los modelos aprenden cosas que no están alineadas con valores éticos. Y, si las empresas quieren tener sistemas más seguros, tendrían que entrenar con datos en los que sí que hubiera este alineamiento, con datos seguros”, subraya el profesor de investigación del Instituto de Investigación de Inteligencia Artificial. El problema es que estos sistemas se entrenan con la información de internet, que contiene de todo. “Otra opción es entrenarlo y después introducirle un componente de valores”, agrega Serramià. “Pero solo cambiaríamos un poco el modelo. La idea sería hacer un cambio más profundo. Pero a nivel de investigación, esto aún no está desarrollado.” Solo queda avanzar paso a paso. “Es importante que las empresas como Anthropic y OpenAI sean conscientes, que lo son, de cuáles son las normas éticas internacionales y hacer que evolucionen a medida que evoluciona la propia tecnología”, incide Salazar. “Porque, al final, la regulación es más estanca. El reglamento europeo de IA trata una serie de casos de uso de alto riesgo que en el futuro podrían estar desactualizados. Es muy importante que estas empresas sigan haciendo pruebas de este tipo”. El reto: agentes de IA que sean segurosTodo indica que será así. A OpenAI, Anthropic y demás les interesa tener sistemas seguros. Más ahora que empiezan a proliferar los agentes de IA, programas autónomos capaces de hacer tareas por sí solos y tomar decisiones. Esta forma de automatizar procesos en las empresas se prevé muy lucrativa. La analista Markets&Markets estima que en 2025 el mercado de los agentes de IA alcanzará los 13.810 millones de dólares. Para 2032, la cifra será de 140.800 millones. “El problema con la seguridad viene porque quieren dotar de autonomía a estos agentes”, indica Rodríguez. “Se tienen que asegurar de que no llevan a cabo acciones inseguras. Y estos experimentos suponen llevar el modelo literalmente al límite”. Y es que si un agente de IA toma decisiones que afectan a un negocio o a la plantilla de una empresa, se debería contar con las máximas garantías. Como recuerda Salazar, una de las claves para mitigar los fallos de seguridad sería colocar a una persona al final del proceso. Anthropic realizó su conflictivo experimento en un caso ficticio y extremo. Y la compañía aseguró que no habían detectado evidencias de problemas de alineación de valores en casos de uso reales de sus herramientas de inteligencia artificial. Con todo, lanzaba una recomendación: tener cautela al desplegar modelos de IA en escenarios con poca supervisión humana y con acceso a información delicada y confidencial.

Cómo es posible que una IA chantajee a su supervisor humano | Tecnología

Shares: